Crean un circuito orgánico capaz de aprender como lo hace el cerebro

Pablo Criado Boado

Un circuito orgánico escalable es capaz de aprender como el perro de Pavlov porque emula la plasticidad sináptica, que es la base de la capacidad de aprendizaje de nuestro cerebro. Se puede implantar en tejido neuronal y su arquitectura anuncia una nueva teoría de la computación.

Un circuito hecho con transistores orgánicos electroquímicos es capaz de aprender como el perro de Pavlov. Forma de pensamiento primaria, pero pensamiento, al fin y al cabo. Además, el estudio tiene tantas y tan poderosas resonancias que vale encarecidamente la pena echarle un ojo. Lo que conocemos por ordenador o computadora está en plena fase de cambio hacia algo mucho más complejo y bello.

Se ha dicho de esta innovación que su resultado es la creación del primer circuito electrónico capaz de pensar como lo hace el cerebro humano. Y esto, sin dejar de tener una base de verdad, es también una exageración.

Ahora bien, no por ello esta innovación carece de interés. Lo tiene y profundo. Eso sí, como suele ocurrir, adquirir una idea nítida sobre cuál es su interés requiere mirar un poquito dentro del asunto y, sobre todo, establecer su contexto.

El artículo que informa de esta innovación, publicado en Nature Communications, establece un primer diseño experimental de un circuito hecho con lo que se ha venido llamando «transistores orgánicos electroquímicos» en el que, en efecto, se ha conseguido un comportamiento de tipo aprendizaje asociativo. En otras palabras, un aprendizaje como el del perro del experimento de Pavlov que, para bien o para mal, sentó las bases de la psicología conductista.

El circuito es extraordinariamente sencillo. Hasta el punto de poder resultar decepcionantemente sencillo. Pero que eso no nos engañe. Posee la importancia de ser una gran prueba de concepto: Nos muestra el que podría ser el (o un) ladrillo fundamental con el que construir circuitos orgánicos mucho más grandes que posean comportamientos adaptativos complejos por medio de aprendizaje asociativo.

Las resonancias de este trabajo son muchas y muy interesantes. Veámoslas.

Resonancias

En términos generales, entronca con los caminos que durante los últimos treinta años se han ido abriendo en esas nuevas-tecnologías-de-antigüedad-milenaria que llamamos tecnologías de la información. Tan antiguas como las primeras civilizaciones humanas por el sencillo motivo de que estas, sin ellas, no habrían sido posibles.

Perdónenme la heterodoxia. No deja de ser una provocación en el sentido de Edward de Bono («provocative operation» o «po»). A veces la utilizo en clase.

Por ejemplo, el artículo en cuestión nos habla de la superación del silicio como paradigma físico de los «cerebros electrónicos», tal y como en tiempos se llamó a los ordenadores o computadoras. Un nombre con aires de pelo afro y película de los 70 y que, en mi opinión, podría ser muchísimo más abarcativo que sus alternativas.

También nos habla de la superación de la matemática booleana (la de ceros y unos) como paradigma lógico de dichos cerebros electrónicos.

Y hasta nos habla (y esto ya es la bomba) de la superación del paradigma arquitectónico que ha sido la base (tal cual o con ligeras modificaciones) de todos los cerebros electrónicos hasta la fecha: la arquitectura de von Neumann.

Esta consiste en concebir un computador (ahora sí utilizo esta denominación, a propósito) como un artilugio hecho de tres partes fundamentales: una unidad de procesamiento, una memoria de datos y una unidad de control que contiene la prescripción de procesamiento y la pauta según los tictacs de un reloj. Por cierto, dicha prescripción de procesamiento no es otra cosa que eso que llamamos «programa».

Así que lo que von Neumann estableció fue el diseño de una máquina automática programable. Esto es, una «máquina universal». Universal en el sentido de que la misma máquina, con solo cambiarle el programa, puede desempeñar funciones completamente diferentes.

Lo mismito que nuestro ordenador, nuestra tablet o nuestro smartphone… ¡que todos ellos, artilugios de von Neumann son!

Ahora bien, el artículo científico que nos ocupa no ha surgido de la nada. Por ejemplo, de transistores orgánicos se habla desde los años ochenta. Y, de hecho, este estudio se fundamenta en un artículo previo al respecto de los mismos autores (“Organic electrochemical transistors”, enero de 2018).

El estudio actual presenta un sencillo circuito capaz de aprendizaje asociativo y cuyos componentes fundamentales son dichos transistores orgánicos. Estos, a un cierto nivel, emulan el funcionamiento del cerebro. Ojo a lo de “a un cierto nivel” (a nivel microscópico, pero no macroscópico).

Porque el cerebro es cosa fina. Tanto que a él mismo le cuesta horrores autoentenderse…

¡Caramba con el cerebro!

El cerebro es un órgano de una complejidad apabullante. Está formado por una cantidad ingente de unidades (neuronas) que poseen un grado de interconectividad altísimo (incluso a larga distancia) y un comportamiento individual nada sencillo.

El cerebro no cumple la máxima de la teoría del caos en su versión mínima: los comportamientos autoorganizados emergen en sistemas de muchas cosas simples. Cumple dicha máxima, pero ¡en su versión máxima!: autoorganización a partir de una cantidad infernal de cosas que, además, distan mucho de ser simples en sí mismas.

Pongamos esto en cifras: 100.000 millones de neuronas (el mismo orden de magnitud al de estrellas en una galaxia mediano-grande como la nuestra); cada una conectada en promedio con otras 10.000 neuronas (mediante una conexión unidireccional que puede llegar a cubrir distancias de centímetros); estando mediada la comunicación de neurona a neurona (sinapsis) por 100 tipos diferentes de moléculas mensajeras (neurotransmisores), y siendo todos estos procesos de tipo electroquímico y naturaleza irreversible.

La irreversibilidad es fundamental. Sin ella nuestro cerebro sería un trasto muy aburrido: su comportamiento futuro sería igual a su comportamiento pasado. En otras palabras, no tendríamos ni memoria ni capacidad de aprendizaje.

Por el contrario, la historia de estímulos de nuestro coco cambia la forma en la que este “está cableado” y, por tanto, lo cambia de una manera mucho más radical a lo que un programa hace con un ordenador (recordemos al Sr. von Neumann).

En concreto, el modelo aceptado al respecto es lo que se llama «plasticidad sináptica». En su versión más sencilla, esta constata el hecho de que un canal sináptico (neurona presináptica + neurotransmisor mediador + neurona postsináptica) se consolida cuanto más se usa.

En otras palabras, nos viene a decir que: “las neuronas que juntas se estimulan, juntas se cablean” (o bien, más castizo, “la repetición crea el hábito”).

Foto: Piqsels.

Foto: Piqsels.Emular al cerebro

Con lo anterior ya tenemos el contexto para ver cómo el circuito propuesto en el artículo emula el cerebro humano.

Además, esto no es nuevo. ¿Qué otra cosa son las redes neuronales?…

Simulaciones normalmente realizadas sobre computadoras convencionales (de tipo von Neumann, con lógica binaria y fabricadas con chips de silicio) que emulan el cerebro. Para ello, están compuestas por muchos procesadores de información (las «neuronas» de la red) de funcionamiento muy sencillito, pero en alto número y con alta interconectividad (incluso recursiva, realimentada).

Y así, incluso con gran número de unidades cuyo comportamiento es muchísimo más sencillo que el de nuestras neuronas, se consiguen los resultados espectaculares que conocemos.

Hablamos de actividades cognitivas de orden superior. No solo recordar datos, acceder a datos o calcular, sino habilidades del tipo reconocimiento de patrones, búsquedas complejas, integración sensorial, control motor…

Ahora bien, mientras la estrategia de emulación del cerebro de las redes neuronales procede de arriba abajo (de lo grande a lo pequeño), la estrategia de emulación que nuestro artículo propone sigue el camino contrario (de lo pequeño a lo grande).

En concreto, los autores del artículo han creado una versión sintética y orgánica (basada en química del carbono, no del silicio) de sinapsis. Una versión que posee irreversibilidad (ellos prefieren llamarla «no-volatilidad»).

Y con esto consiguen algo muy notable: dicha irreversibilidad, que ya hemos visto que es el motor de la memoria (y, consiguientemente, del aprendizaje), se produce en el propio dispositivo sináptico.

En otras palabras: la unidad de procesamiento y la unidad de memoria no son en este caso dos partes separadas, sino que están fundidas en una. Y, por tanto, con esto se supera por completo la arquitectura de von Neumann. (¡!).

Y, recordémoslo ahora, así es como funciona nuestro cerebro a pequeña escala: almacenando información en los canales de comunicación entre neuronas (plasticidad sináptica). Nuestro cerebro no es, en absoluto, un artilugio de von Neumann.

¿Transistores orgánicos?

En este apartado y el siguiente descendemos a un nivel de detalle que podría resultar aburrido a algunos de ustedes. El objetivo es desentrañar el detalle de lo que dice el artículo científico. Yo estoy obligado a hacerlo por integridad de la narración. Pero si a usted esto no le motiva especialmente, le pido que no ponga clics en polvorosa, sino que salte lectura directamente a la sección final de conclusiones.

Los autores han creado una versión mejorada de los ya añejos transistores orgánicos electroquímicos.

Un transistor es un cacharrito con dos entradas y una salida. Una de las entradas es la fuente (S, de “source”), la otra entrada es la base (G, de “gate”) y la salida es el drenaje (D, de “drain”). Y resulta que la señal en D no sólo depende de S, sino también de G. Según qué señal pongamos en G, el transistor funcionará de tres formas diferentes: como interruptor (VD=0, voltaje en D), como conductor (VD=VS) o como amplificador (VD>VS).

Los transistores miniaturizados que se pueden imprimir sobre obleas de material semiconductor (casi siempre, silicio) han permitido crear, mediante asociación de varios, las llamadas «puertas lógicas» que dan forma a cada una de las operaciones de la matemática de ceros y unos booleana (AND, OR, NOT, etc.). Y así fue como surgieron los ordenadores que hoy nos rodean por todas partes.

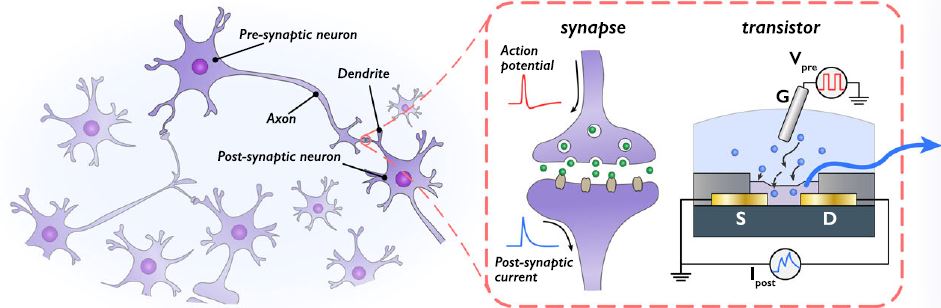

Por su parte, los transistores orgánicos electroquímicos permiten emular un canal sináptico tal y como nos muestra la siguiente ilustración.

Ilustración extraída del artículo.

Ilustración extraída del artículo.Hay un detalle que este esquema no hace patente y que resulta importante para entender el asunto. La conexión entre la fuente (S) y el drenaje (D) consiste en un material dual formado un canal conductor (un polímero orgánico) recubierto por un material electrolítico (que permite el movimiento de iones dentro de él).

Pues bien, dicho transistor orgánico emula la conexión sináptica donde la base (G) hace la función de estímulo emitido por la neurona presináptica (potencial de acción), y la corriente ISD que desde la fuente (S) llega al drenaje (D) hace la función de estímulo recibido en la neurona postsináptica (corriente postsináptica). Eso justamente es lo que nos cuenta la ilustración.

Además, podemos generar transistores orgánicos de este tipo en dos variantes: sin memoria (volátiles) y con memoria (no-volátiles). Y la gracia está en que con los de la segunda variante, una vez les hemos aplicado un voltaje en la base (G), la conexión entre fuente (S) y drenaje (D) queda afianzada.

El motivo es que la aplicación de dicho potencial en la base (G) ha generado una acumulación permanente (como la memoria) de iones en la parte del material electrolítico en directo contacto con el canal conductor (recuérdese que el material era doble).

¡Y este fenómeno electroquímico es el que, en definitiva, emula el proceso de plasticidad sináptica!

Emulación del aprendizaje asociativo

Llegados aquí, ya podemos por fin desentrañar el meollo y gran novedad del artículo: proponer un sencillo circuito que aprende a asociar dos estímulos igual que hacía el perro de Pavlov.

Recordemos que el Sr. Pavlov sometió a su perro al siguiente experimento:

Primero le enseñó comida (US, de “unconditioned stimulus” o estímulo no condicionado) y el perro salivaba (UR, de “unconditioned response” o respuesta no condicionada).

Después, le tocó una campana (CR, de “conditioned stimulus” o estímulo condicionado) y, claro, al perro le traía al pairo la campana (no salivaba).

A continuación, le tocó la campana mientras le enseñaba comida y, por tanto, mientras el perro salivaba. Y resulta que tras repetir esto último varias veces, al final, con solo tocar la campana el perro salivaba.

Un aprendizaje digno de cenutrios, pensamos todos. Pero aprendizaje, al fin y al cabo. Y hace falta una suerte de cerebro para que acontezca.

Pues bien, el circuito propuesto por los autores del artículo aprende de la misma forma.

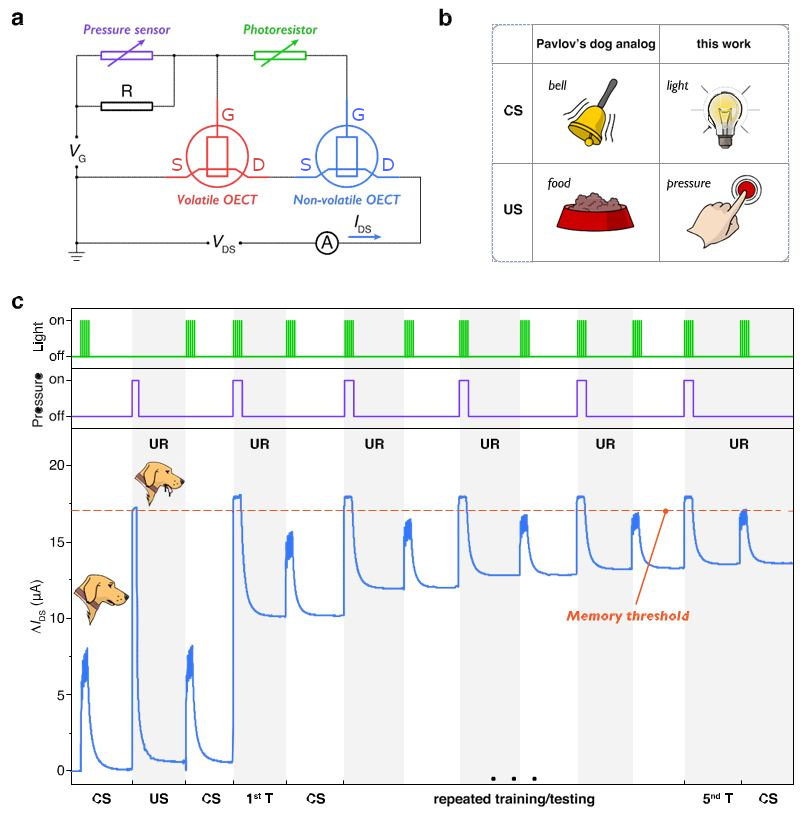

Dicho circuito está constituido por dos interruptores que se cierran uno al pulsarlo (sensor de presión) y otro al iluminarlo (fotorresistor), así como por dos transistores orgánicos, uno de ellos volátil (sin memoria) y el otro no-volátil (con memoria) montados en serie (uno a continuación del otro, de tal forma que sus efectos se suman).

Además, el interruptor de presión está puenteado por una resistencia (R) que, y esto es importante, es muy grande (13 megaohmios).

Ilustración extraída del artículo.

Ilustración extraída del artículo.Así las cosas, al cerrar el fotorresistor solo (ya sea antes o después de haber activado el sensor de presión), la corriente que atraviesa ambos transistores no supera el umbral de respuesta (cifrado en unos 17 microamperios, μA). Y esto debido a que la gran resistencia R hace que el voltaje en la base (G) del transistor no volátil no resulte lo suficientemente grande para generar un efecto memoria apreciable en él.

Sin embargo, al apretar solo el pulsador la corriente sí crece notablemente debido al efecto de dicho pulsador en el transistor volátil. Sin embargo, cuando lo dejamos de pulsar, todo vuelve a su estado inicial. Y esto, precisamente, porque dicho transistor es volátil (no genera efecto memoria).

Ahora bien, al apretar el pulsador y activar el fotorresistor al mismo tiempo, el voltaje que llega a la base (G) del transistor no-volátil es lo suficientemente grande como para generar un efecto memoria notable.

Y si esto se repite cinco veces, el efecto memoria acumulado es tan grande que ahora sí, con solo activar el fotorresistor (esto es, sin apretar el pulsador) y aunque el voltaje sobre la base (G) del transistor no-volátil sea pequeño, este transistor ya está tan afianzado (emulando el proceso de plasticidad sináptica) que la corriente supera el umbral y, por tanto, hay estímulo. En otras palabras, el perrito saliva.

Por tanto, hemos emulado el aprendizaje asociativo. O lo que es lo mismo, hemos creado un perro de Pavlov con dos transistores orgánicos y un poco más.

Eso sí, siendo rigurosos habría que pedir a los autores que mostrasen que la activación repetida de solo el fotorresistor no llega nunca a acumular un efecto memoria tal que llegue a producir respuesta (señal por encima del umbral de 17 microamperios o, lo que es lo mismo, o salivación perruna).

Pero bueno, por eso los artículos científicos son tan detallados. Para que otros equipos de investigación puedan reproducir los montajes experimentales y comprobar que se obtienen los resultados proclamados en el artículo.

Conclusión

Por tanto, los autores del estudio han refinado los transistores orgánicos de forma que es posible emular con ellos la plasticidad sináptica que es la base a pequeña escala (no a gran escala) de la capacidad de aprendizaje de nuestro cerebro.

Y esto lo demuestran presentándonos un sencillo circuito construido con dos de esos transistores orgánicos (uno con y otro sin memoria) de forma que sirve como prueba de concepto. Es un prototipo básico de sistema electrónico sintético (y hecho con materiales orgánicos, basados en carbono) que posee un comportamiento equivalente al aprendizaje asociativo del perro de Pavlov: aprender a asociar un estímulo inicialmente neutro (campana, estímulo condicionado), con la respuesta (salivación) a un estímulo natural (mostrar comida, estímulo no condicionado).

Parece claro que, tal y como nos dicen los autores, este sencillo circuito se puede complicar para incorporar tanto sensores como queramos y conseguir que su comportamiento sea más o mucho más sofisticado.

Además, dado que está construido con materiales orgánicos, posee una biocompatibilidad mucho mayor que los componentes electrónicos convencionales. Y esto hace que pueda llegar a resultar implantable para, por ejemplo, conectarlo directamente con tejido neuronal.

Además (como interesantísimo resultado a nivel teórico), este artículo nos muestra que la arquitectura de ordenadores («cerebros electrónicos») que ha regido hasta la fecha (modelo de von Neumann) está empezando a quedar obsoleta.

En este sentido, estemos atentos a aprender de la goleada que va a sufrir la física determinista y reversible de la computación basada en semiconductores (v.g., silicio) por parte de la no determinista computación cuántica y de la no reversible computación en sistemas orgánicos.

Mi opinión es que, con esto, la ciencia de la computación dejará de ser “de la computación” (mero cálculo) para transformarse en algo mucho más complejo y bello. Y si no me equivoco en esto, vamos camino de una nueva teoría de la computación. Un horizonte magnífico.

Por otra parte, en el camino de desentrañar este artículo hemos recordado que la plasticidad sináptica determina que ¡a nuestro cerebro le resulta más fácil aprender que desaprender!

Quizás por eso sucede que los prejuicios y los sesgos de todo tipo son tan difíciles de desterrar. Prejuicios de género, prejuicios sobre la transexualidad, prejuicios sobre las identidades nacionales, prejuicios sobre supremacismos raciales… Nuestra maestría de inventar formas de entender la vida debería, al menos así me parece, ser correspondida por una similar competencia para aprender a respetarlas.

Y no olvidemos los prejuicios de conocimiento. Sobre todo, los de aquellos conocimientos cuya adquisición nos ha costado tanto esfuerzo y repetición (como los obtenidos en la escuela, en la universidad o en nuestro puesto de trabajo). El conocimiento es, al mismo tiempo, alas y lastre.

_________________

Referencia

“Mimicking associative learning using an ion-trapping non-volatile synaptic organic electrochemical transistor” (Nature Communications. Xudong Ji, Bryan D. Paulsen, Gary K. K. Chik, Ruiheng Wu, Yuyang Yin, Paddy K. L. Chan & Jonathan Rivnay).

Foto superior: Piqsels.

____________

Fuente: